Türkçe için öne çıkan açık kaynak modeller

Türkçede üretken yapay zeka ekosistemi hızla büyürken, açık kaynak modeller de hem performans hem de erişilebilirlik açısından dikkat çekiyor. Bu liste; akıl yürütme, metin üretimi ve arama/benzerlik (embedding) gibi farklı ihtiyaçlara göre ince ayar yapılmış Türkçe odaklı modelleri bir araya getiriyor. Kurum ve topluluk katkılarıyla gelişen bu modeller, Türkçede daha tutarlı çıktı ve daha iyi talimat takibi hedefliyor

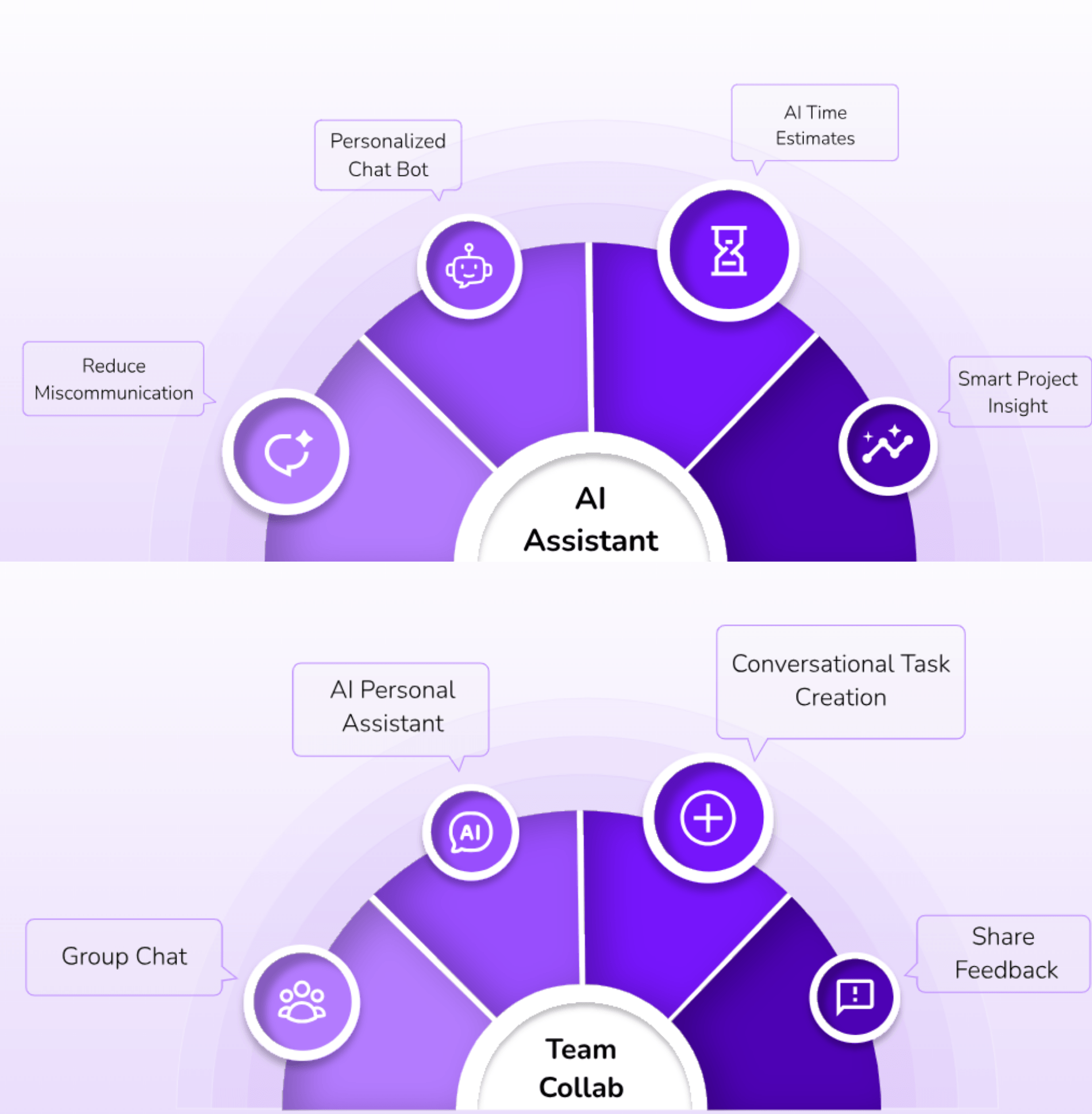

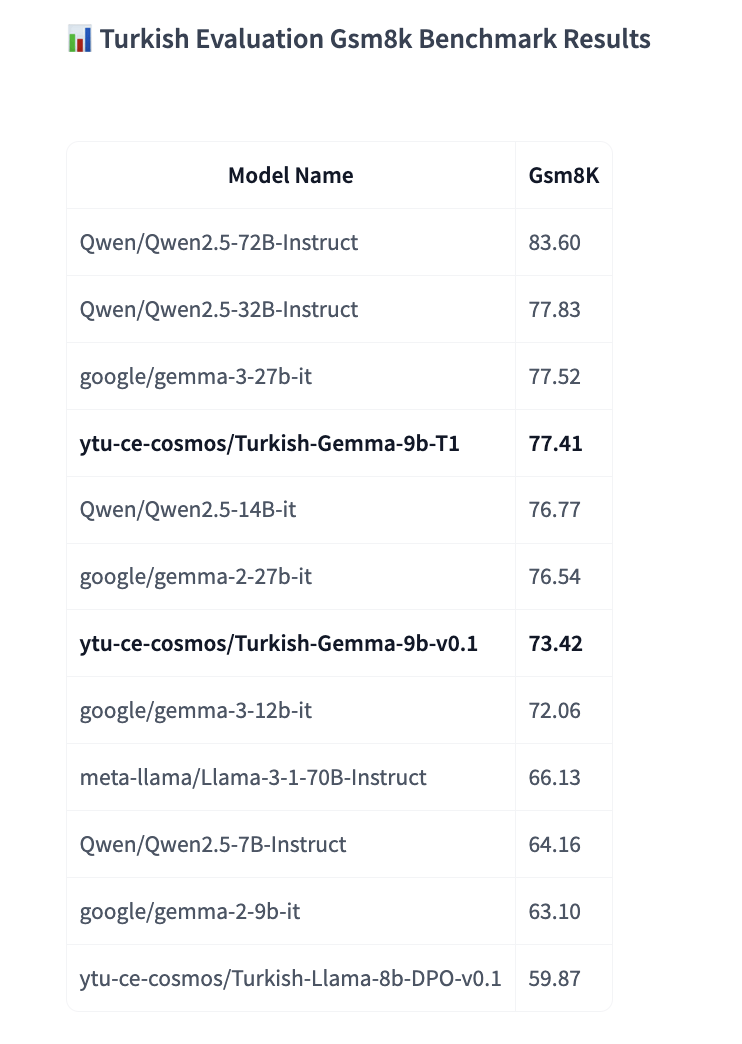

ytu-ce-cosmos/Türkçe-Gemma-9b-v0.1’ı temel alan Türkçe-Gemma-9b-T1, Türkçede çok adımlı muhakeme ya da başka bir deyişle düşünme için özel olarak uyarlandı. Matematik problemleri, mantıksal akıl yürütme, adım adım çıkarım ve planlama görevlerinde daha iyi performans gösterecek şekilde tasarlanan model, talimatları takip ederek net ve özlü yanıtlar üretiyor

Türkçe-Gemma-9b-T1, çok adımlı akıl yürütme söz konusu olduğunda birden fazla koşul söz konusu olduğunda daha güçlü ara çıkarım sunuyor. Matematik ve mantık açısından aritmetik, olasılık, diziler, rasyonel akıl yürütme ve mantık bulmacalarında doğruluğun iyileştirildiği belirtiliyor. Talimatlara daha iyi uyum gösteren akıl yürütme modeli daha az halüsinasyon görürken, temelli cevaplara odaklanırak gerektiğinde belirsizliği belirtiyor.

Türkçe-e5-Large çeşitli Türkçe veri kümeleriyle intfloat/multilingual-e5-large-instruct modelinin ince ayar versiyonu olarak karşımıza çıkıyor. Türkçe özelinde arama sorgularına kolaylıkla yanıt veren Türkçe-e5-Large, Yıldız Teknik Ünversitesi Cosmos Yapay Zeka Araştırma Grubu tarafından geliştirildi. Model, Hugging Face’te geçtiğimiz ay 1700’den fazla kez indirildi.

Turkish-Llama-8b-v0.1, 30 GB’lık Türkçe veri seti ile LLaMA-3 8B modelinin tamamen ince ayarlanmış bir versiyonu.

Metin üretme görevleri için tasarlanan model, belirli bir metin parçasını tutarlı ve bağlamsal olarak alakalı bir şekilde devam ettirme yeteneğiyle öne çıkıyor. Öte yandan modelin, web siteleri, kitaplar ve diğer metin kaynaklarını içeren eğitim verilerinin çeşitliliği nedeniyle önyargılar sergileyebilieceği belirtiliyor.

Bert-base-turkish-cased ile Bavyera Devlet Kütüphanesi’ndeki MDZ Dijital Kütüphane ekibi, Türkçe için bir cased modeli açık kaynak olarak yayınladı. Bu arada Türkçe için topluluk odaklı bir cased BERT modeli olan BERTurk’ten de bahsetmekte fayda var. Ön eğitim ve değerlendirme için kullanılan bazı veri kümeleri, bu Türkçe NLP topluluğu tarafından sağlandı. Modelin adı olan BERTurk de bu topluluk tarafından belirlendi. İstatistik Modelin mevcut sürümü, filtrelenmiş ve cümle segmentlerine ayrılmış Türkçe OSCAR corpus, son Wikipedia dökümü, çeşitli OPUS corpus ve Kemal Oflazer tarafından sağlanan özel bir corpus üzerinde eğitildi.

Türkçe için bir ELECTRA temel modeli olan electra-base-turkish-cased-discriminator, Bavyera Devlet Kütüphanesi’ndeki MDZ Dijital Kütüphane ekibi tarafından açık kaynak olarak yayınlandı. Türkçe ELECTRA modeli BERTurk ile aynı verilerle eğitilmiş Türkçe için bir temel ELECTRA modeli olarak karşımıza çıkıyor. ELECTRA’nın özdenetimli dil temsil öğrenimi için yeni bir yöntem olduğu belirtiliyor. Nispeten az hesaplama gücü kullanarak dönüştürücü ağları önceden eğitmek için kullanılabilir. ELECTRA modelleri, GAN’ın ayırt edicisine benzer şekilde, “gerçek” girdi token’larını başka bir sinir ağı tarafından üretilen “sahte” girdi token’larından ayırt etmek için eğitilir.Modelin mevcut sürümü ise Türkçenin OSCAR corpus’unun filtrelenmiş ve cümle segmentlerine ayrılmış bir versiyonu, Wikipedia’nın son dökümü, çeşitli OPUS corpus’ları ve Kemal Oflazer tarafından sağlanan özel bir corpus üzerinde eğitildi.